티스토리 뷰

반응형

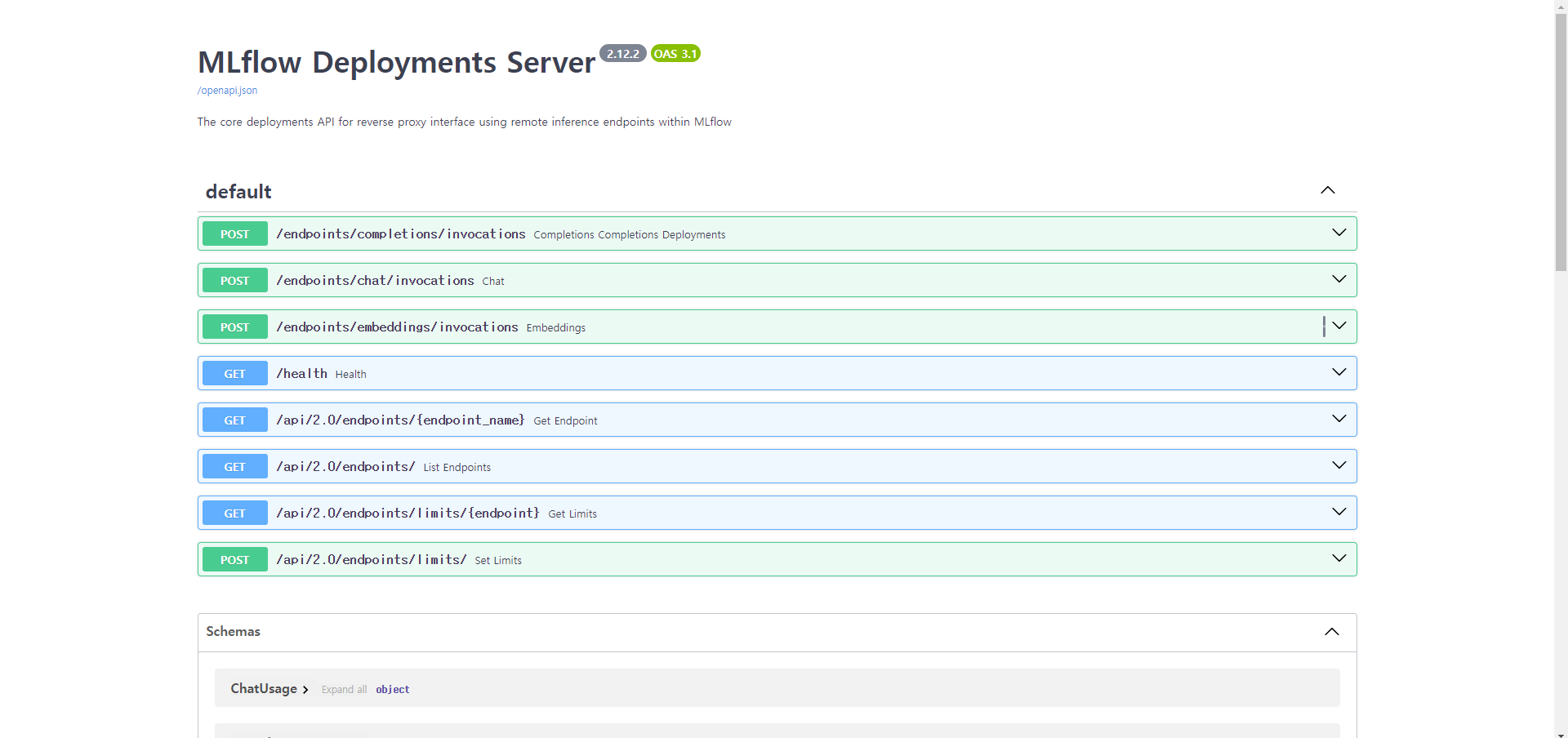

mlflow에 LLM Deployment Server를 사용하는 방법이 있어 실제로 실습을 진행했다.

Config.yaml

endpoints:

- name: completions

endpoint_type: llm/v1/completions

model:

provider: openai

name: gpt-3.5-turbo

config:

openai_api_key: $OPENAI_API_KEY

- name: chat

endpoint_type: llm/v1/chat

model:

provider: openai

name: gpt-4

config:

openai_api_key: $OPENAI_API_KEY

- name: chat_3.5

endpoint_type: llm/v1/chat

model:

provider: openai

name: gpt-3.5-turbo

config:

openai_api_key: $OPENAI_API_KEY

- name: embeddings

endpoint_type: llm/v1/embeddings

model:

provider: openai

name: text-embedding-ada-002

config:

openai_api_key: $OPENAI_API_KEY

$OPENAI_API_KEY 환경 변수를 입력해야하기 때문에 도커를 활용하여 환경 변수를 주입하였다.

DockerCompose

mlflow-deployment:

container_name: mlflow-deployment

build:

dockerfile: ops/deployment/Dockerfile

env_file:

- .env.dev

ports:

- "7001:7001"

command: mlflow deployments start-server --config-path /mlflow_deployment/config.yaml --host 0.0.0.0 --port 7001

.env.dev 파일에 OPENAI_API_KEY 환경 변수에 값을 넣고 컨테이너를 만들때 환경변수가 주입되도록 설정하였다. 이후 서버에 접속을 하게되면 기본으로 API를 살펴볼수있는 Swagger를 제공해준다.

답변이 잘 나오는 것을 확인할 수 있다.

반응형

'DevOps' 카테고리의 다른 글

| [Docker] 도커 컨테이너 안에서 Cron 설정 (1) | 2023.09.21 |

|---|---|

| [Docker] 파이썬으로 컨테이너 구성해서 주기적인 GET 요청 (0) | 2023.09.21 |

| [Apache] 자식 프로세스 생성 방식 prefork, worker (1) | 2021.03.20 |

| 리눅스 서버 상태 체크하기-vmstat 분석 (2) | 2021.02.28 |

반응형

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- FastAPI

- 분산시스템

- Python

- 파이썬

- 프로그래머스

- 다이나믹프로그래밍

- 시간초과

- 자료구조

- 딥러닝

- lightsail

- 정보보안

- 코딩테스트

- LangChain

- 그리디

- 리눅스

- 보안

- springboot

- Ai

- huggingface

- 보안기사

- synflooding

- 카카오페이면접후기

- linux

- 백준

- 우선순위큐

- t-test

- llm

- 정보보안기사

- 카카오페이

- java

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

글 보관함